Self-Adapting Language Models (SEAL) 논문 리뷰

1. 연구의 필요성 및 배경: LLM의 한계와 자기 적응의 중요성

대규모 언어 모델(LLMs)은 방대한 텍스트 코퍼스에서 사전 학습되어 언어 이해 및 생성 분야에서 놀라운 능력을 보여주지만, 본질적으로 정적(static)인 특성을 가집니다. 즉, 새로운 작업, 지식 또는 예시에 직면했을 때 자체 가중치를 적응시키는 메커니즘이 부족합니다. 특정 작업에 모델을 적응시키거나, 새로운 정보를 통합하거나, 새로운 추론 능력을 습득하는 것은 작업별 데이터의 가용성이 제한적이기 때문에 여전히 어렵습니다.

SEAL 논문은 이러한 한계를 극복하기 위해 흥미로운 가설을 탐구합니다: LLM이 자체 훈련 데이터를 변형하거나 생성하고 학습 절차를 변환하거나 생성함으로써 스스로 적응할 수 있을까?. 이는 마치 기계 학습 수업에서 기말고사를 준비하는 인간 학생에 비유될 수 있습니다. 학생들은 강의 내용이나 교과서, 인터넷 정보와 같은 원시 콘텐츠에만 의존하기보다는, 그 정보를 자신만의 방식으로 재해석하고(reinterpreting), 보강하고(augmenting), 다시 작성하는(rewriting) 과정을 통해 내용을 더 잘 이해하고 시험 문제에 답하는 능력을 향상시킵니다. 이처럼 데이터를 재구성하거나 다시 작성하는 과정은 인간 학습 전반에 걸쳐 보편적으로 나타나는 현상입니다. 반면, 현재 LLM은 새로운 작업이 주어지면 단순히 작업 데이터를 "있는 그대로(as-is)" 소비하고 학습하는 방식(미세 조정 또는 인-컨텍스트 학습)을 따릅니다. SEAL은 데이터가 학습에 최적의 형식이나 볼륨이 아닐 수 있다는 점을 지적하며, 모델이 훈련 데이터를 가장 잘 변환하고 학습하는 맞춤형 전략을 개발할 수 있도록 하는 것을 목표로 합니다.

2. SEAL의 핵심 메커니즘: 자기 편집(Self-Edits)과 중첩된 학습 루프

SEAL은 언어 모델에 자체 훈련 데이터를 생성하고, 해당 데이터를 활용하기 위한 미세 조정 지침을 생성하는 능력을 부여함으로써 이러한 자기 적응을 가능하게 합니다. 이를 위해 모델이 "자기 편집(self-edits)"을 생성하도록 훈련하는 강화 학습(RL) 루프를 사용합니다. 자기 편집은 정보 재구성, 최적화 하이퍼파라미터 지정, 데이터 증강 도구 호출, 경사 기반 업데이트 등 가중치를 업데이트하는 지시 사항을 포함할 수 있는 자연어 지침입니다.

SEAL은 두 개의 중첩된 루프(nested loops)를 가진 알고리즘으로 해석될 수 있습니다:

- 내부 업데이트 루프 (Inner Update Loop):

- 이 루프는 모델이 생성한 자기 편집(SE)을 사용하여 모델의 가중치를 업데이트합니다.

- 주어진 컨텍스트(C)와 다운스트림 평가(τ)에 대해, 모델은 자기 편집(SE)을 생성하고 지도 미세 조정(Supervised Finetuning, SFT)을 통해 파라미터 $θ$를 $θ'$로 업데이트합니다: $θ' ← \text{SFT}(θ, \text{SE})$.

- 이러한 업데이트는 지속적인 가중치 업데이트를 가능하게 하여 지속적인 적응으로 이어집니다.

- 업데이트당 적은 양의 데이터와 총 업데이트 횟수가 많다는 점을 고려하여, 효율적이고 경량화된 튜닝을 위해 LoRA(Low-rank adapters)가 사용됩니다.

- 외부 RL 루프 (Outer RL Loop):

- 이 루프는 자기 편집 생성 정책을 최적화합니다. 모델은 자기 편집을 생성하는 "행동(action)"을 취하고, 업데이트된 모델($\text{LM}_{θ'}$)의 다운스트림 작업 성능에 기반한 "보상(reward)"을 받습니다. 이 보상은 자기 편집 생성 정책을 개선하는 데 사용됩니다.

- $\mathcal{L}_{\text{RL}}(\theta_t):= - \mathbb{E}_{(C, \tau) \sim \mathcal{D}} \left[ \mathbb{E}_{\text{SE} \sim \text{LM}_{\theta_t}(\cdot|C)} \left[ r(\text{SE}, \tau, \theta_t) \right] \right]$. 여기서 보상 함수 $r(\text{SE}, τ, θ_t)$는 $LM_{θ'}$의 $τ$에 대한 성능에 따라 계산됩니다.

- 표준 RL 설정과 달리, SEAL에서는 주어진 행동에 할당되는 보상이 행동이 취해지는 시점의 모델 파라미터 $θ$에 의존합니다 (왜냐하면 $θ$가 $θ'$로 업데이트된 후 평가되기 때문입니다). 이는 기본 RL 상태에 정책의 파라미터가 포함되어야 함을 의미합니다. 이러한 이유로, SEAL은 온-폴리시(on-policy) 접근 방식을 채택합니다. 즉, 자기 편집은 현재 모델에서 샘플링되고 보상도 현재 모델을 사용하여 계산됩니다.

- 저자들은 GRPO나 PPO와 같은 온-폴리시 방법을 실험했으나 훈련 불안정성을 발견했고, 대신 ReSTEM이라는 보다 간단한 접근 방식을 채택했습니다. ReSTEM은 필터링된 행동 클로닝(filtered behavior cloning), 즉 "리젝션 샘플링 + SFT"에 기반하며, EM(Expectation-Maximization) 절차로 볼 수 있습니다:

- E-단계: 현재 모델 정책에서 후보 자기 편집(SE)을 샘플링합니다.

- M-단계: 긍정적인 보상($r=1$)을 받은 샘플만 지도 미세 조정을 통해 강화합니다. 이는 보상 항에 스톱-그레이디언트를 적용하여 이진 보상 $r(\text{SE}, τ, θ_t) = 1$일 때만 $∇_{θ_t} \log p_{θ_t}(\text{SE}_{ij} | C_i)$를 계산하는 방식으로 최적화됩니다.

- SEAL은 모델이 효과적인 자기 편집을 생성하는 방법을 학습하는 메타 학습(meta-learning)의 한 예시로 볼 수 있습니다. 궁극적으로 모델 자체의 생성 능력을 활용하여 적응 프로세스를 파라미터화하고 제어합니다.

3. 적용 분야 및 상세 실험 결과

SEAL은 두 가지 주요 애플리케이션에서 평가되었습니다:

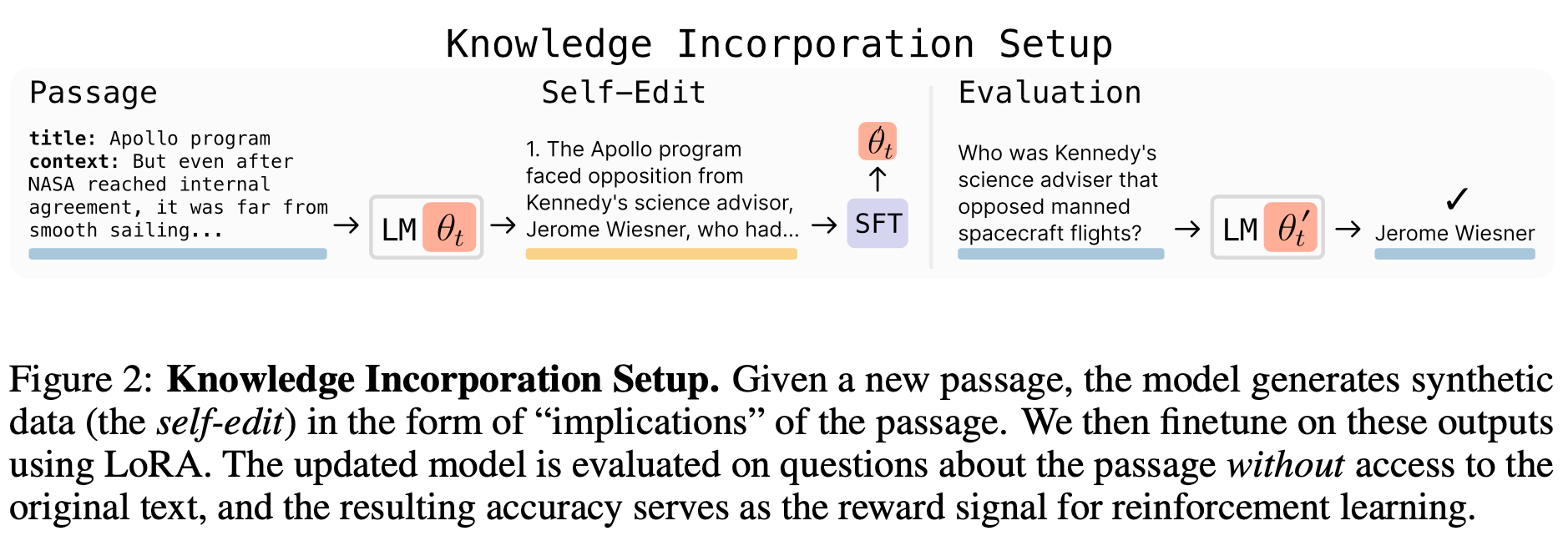

- 지식 통합 (Knowledge Incorporation):

- 목표: LLM에 새로운 사실적 지식을 효율적으로 통합하여, 원본 텍스트에 접근하지 않고도 해당 지식을 회상할 수 있도록 하는 것입니다.

- 방법: 모델은 주어진 지문에서 "함의(implications)" 형태의 합성 데이터를 생성합니다. 예를 들어, 모델은 "List several implications derived from the content"와 같은 프롬프트를 받아 지문에서 추론, 논리적 결과 또는 원본 지문의 재진술을 포함하는 함의를 생성합니다. 그 후, 원본 지문과 생성된 함의에 대해 미세 조정을 수행합니다. 업데이트된 모델은 원본 텍스트에 접근하지 않고 지문에 대한 질문에 답변하는 능력으로 평가되며, 그 정확도가 강화 학습의 보상 신호로 사용됩니다.

- 모델 및 데이터: Qwen2.5-7B 모델과 SQuAD v1.1 데이터셋을 사용했으며, SQuAD의 "no-passage-in-context" 변형으로 평가했습니다.

- 결과:

- 강화 학습 훈련 후, 자체 생성된 합성 데이터로 미세 조정하는 것이 SQuAD의 질문-답변 성능을 33.5%에서 47.0%로 향상시켰습니다.

- 특히, SEAL에서 생성된 데이터는 GPT-4.1이 생성한 합성 데이터보다 성능이 우수했습니다 (47.0% vs. 46.3%). 이는 자기 편집 정책이 지문을 쉽게 학습 가능한 원자적 사실(atomic facts)로 증류하는 스타일로 빠르게 수렴함을 시사합니다.

- "Continued Pretraining (CPT)" 설정(200개 지문)에서도 SEAL은 모든 베이스라인을 능가하여 43.8%의 정확도를 달성했습니다. 이는 SEAL이 발견한 편집 정책이 단일 지문 생성이라는 원래 RL 설정 이상으로 일반화됨을 시사합니다.

- 다양한 프롬프트(예: implications, rewrite, self-qa)를 실험했으며, SEAL은 모든 경우에 초기 성능을 6~11% 포인트 향상시켰습니다. 이는 RL 훈련을 통해 프롬프트만으로 얻을 수 있는 이점을 넘어 추가적인 성능 향상이 가능함을 보여줍니다.

- 퓨샷 학습 (Few-Shot Learning):

- 목표: 매우 제한된 예시로부터 추상적 추론 및 일반화를 테스트하는 것입니다.

- 방법: 모델이 데이터 증강 및 최적화 설정을 자율적으로 선택하도록 훈련시킵니다. 모델은 퓨샷 데모를 프롬프트로 받아, 어떤 도구를 호출하고 어떻게 구성할지 지정하는 자기 편집을 생성합니다. 이러한 자기 편집은 데이터 증강 유형(회전, 뒤집기, 크기 조정 등)과 최적화 파라미터(학습률, 에폭 수, 손실 계산 방법)를 포함합니다. 이후 LoRA 기반 미세 조정을 통해 모델이 적응하고, 그 결과(홀드아웃 테스트 입력에 대한 정확도)가 자기 편집 생성 정책 훈련의 보상으로 사용됩니다.

- 모델 및 데이터: Llama-3.2-1B-Instruct 모델과 ARC-AGI 벤치마크의 간소화된 하위 집합(11개 훈련 작업, 8개 평가 작업)을 사용했습니다.

- 결과: SEAL은 표준 인-컨텍스트 학습(ICL) 및 RL 훈련 없는 자기 편집에 비해 적응 성공률을 크게 향상시켰습니다.

- ICL: 0% 성공률.

- TTT + Self-Edit (RL 훈련 없음): 20% 성공률.

- SEAL: 72.5% 성공률 [8, 31, Table 1].

- 이는 SEAL이 언어 모델의 자기 적응을 가능하게 하는 다용도 프레임워크임을 강력하게 보여줍니다. Oracle TTT(인간이 최적의 구성을 수동으로 설정한 경우)는 100% 성공률을 보였는데, 이는 SEAL이 여전히 개선될 여지가 있음을 시사합니다.

4. 관련 연구와의 비교 (차별점 강조)

SEAL은 다양한 관련 연구 분야와 연결되지만, 명확한 차별점을 가집니다:

- 합성 데이터 생성 (Synthetic Data Generation): 기존 방식은 정적이거나 휴리스틱 기반인 반면, SEAL은 강화 학습을 사용하여 합성 데이터의 다운스트림 유용성을 직접적으로 최대화하도록 생성 정책을 훈련합니다.

- 지식 업데이트 (Knowledge Updating): 기존 연구들이 사실적 지식을 직접 파라미터에 삽입하거나 추가 미세 조정 데이터를 생성하는 방법을 제안했지만, SEAL은 RL을 통해 더욱 최적의 미세 조정 데이터를 생성하도록 모델을 훈련합니다.

- 테스트-시간 훈련 (Test-Time Training, TTT): TTT는 모델 가중치를 임시적으로 조정하지만, SEAL은 TTT를 내부 루프 최적화에 통합하여 효율적인 업데이트와 보상을 계산하는 데 활용합니다.

- LLM을 위한 강화 학습 (Reinforcement Learning for LLMs): 기존 RL이 최종 답변이나 추론 과정을 최적화하는 데 사용된 반면, SEAL은 가중치 업데이트에 사용될 자기 편집 데이터의 생성을 최적화합니다.

- 메타 학습 (Meta-Learning): SEAL은 효과적인 자기 편집을 생성하는 "적응 전략"을 학습하는 메타 학습 원리를 구현합니다.

- 자기 개선 (Self-Improvement): RLAIF나 자기 보상 언어 모델과 같은 기존 자기 개선 방법은 모델 자체의 평가 능력이나 자기 일관성에 의해 제한되는 반면, SEAL은 외부 데이터와의 상호작용을 통해 자기 개선을 바라보며, 이 외부 데이터를 자기 개선에 가장 잘 활용하는 방법을 학습합니다.

5. 한계점 (구체적인 문제점 및 해결 방안)

논문은 다음과 같은 주요 한계점을 언급합니다:

- 파국적 망각 (Catastrophic Forgetting):

- 새로운 정보가 연속적으로 통합될 때, 모델이 이전 지식을 손실할 수 있습니다.

- SEAL은 현재 이러한 망각을 명시적으로 최적화하지 않지만, 저자들은 지식 통합 영역에서 연속 학습 설정을 시뮬레이션하여 이 문제에 대한 기준선을 설정했습니다. 결과는 그림 6에서 볼 수 있듯이, 편집 횟수가 증가함에 따라 이전 작업에 대한 성능이 점진적으로 감소함을 보여주며, SEAL이 여전히 파국적 망각에 취약함을 시사합니다.

- 향후 연구에서는 보상 형성(reward shaping)을 통해 이전 작업에 대한 성능 저하를 제재하거나, null-space 제약 편집(null-space constrained edits) 또는 표현 중첩(representational superposition)과 같은 연속 학습 전략을 통합하여 이 문제를 개선할 수 있음을 제시합니다.

- 계산 오버헤드 (Computational Overhead):

- 보상을 계산하기 위해 전체 모델을 미세 조정하고 평가해야 하므로, TTT 보상 루프는 다른 LLM용 RL 루프보다 상당히 더 많은 계산 비용이 듭니다.

- 각 자기 편집 평가에는 약 30-45초가 소요되며, ReSTEM 훈련의 E-단계(모델이 자기 편집을 생성하고 미세 조정 및 추론을 통해 등급을 매기는 과정)는 단일 라운드에 2개의 H100 GPU에서 약 6시간이 걸립니다. 이는 상당한 오버헤드를 발생시킵니다.

- 맥락 의존적 평가 (Context-Dependent Evaluation):

- 현재 SEAL의 구현은 모든 맥락이 명시적인 다운스트림 작업과 짝을 이루어야 한다고 가정합니다 (예: 퓨샷 데모와 홀드아웃 질의-응답 쌍, 각 지문에 대한 참조 QA).

- 이러한 결합은 보상 계산을 단순화하지만, 레이블이 없는 코퍼스(unlabeled corpora)로 RL 훈련을 확장하는 것을 방해합니다.

- 잠재적인 해결책은 모델이 자기 편집뿐만 아니라 자체 평가 질문을 생성하도록 하는 것입니다 (예: 각 지문에 대한 QA 항목 또는 합성 테스트 케이스 초안 작성). 이렇게 모델이 작성한 쿼리는 강화 학습에 필요한 즉각적인 감독을 제공하여 일반적인 훈련 도메인으로의 적용 가능성을 넓힐 수 있습니다.

6. 결론 및 향후 전망

SEAL은 LLM이 사전 훈련 후 정적인 상태로 머물 필요가 없음을 분명히 보여줍니다. 모델이 자체적인 합성 자기 편집 데이터를 생성하고 경량화된 가중치 업데이트를 통해 이를 적용함으로써, 새로운 지식을 자율적으로 통합하고 새로운 작업에 적응할 수 있습니다.

저자들은 2028년경에 최첨단 LLM이 공개적으로 사용 가능한 모든 인간 생성 텍스트로 훈련될 것이라는 "데이터 장벽(data wall)"에 직면할 것이라고 예상하며, 이러한 상황에서는 합성 데이터 증강이 필수적일 것이라고 주장합니다. 궁극적으로는 전용 SEAL 합성-데이터 생성 모델을 메타-훈련하여 미래 모델이 추가적인 인간 텍스트에 의존하지 않고도 확장하고 더 큰 데이터 효율성을 달성할 수 있도록 하는 것을 목표로 합니다.

이러한 지속적인 자기 개선 루프는 다음과 같은 분야에서 유망합니다:

- 에이전트 시스템 (Agentic Systems) 구축: 모델이 확장된 상호작용을 통해 작동하고 진화하는 목표에 동적으로 적응할 수 있도록 합니다. 에이전트 모델은 행동하면서 점진적으로 지식을 습득하고 유지해야 하는데, SEAL은 구조화된 자기 수정(structured self-modification)을 가능하게 함으로써 이를 지원합니다. 상호작용 후 에이전트는 자기 편집을 합성하여 가중치 업데이트를 유발하고, 이를 통해 시간이 지남에 따라 행동을 발전시키고 반복적인 감독에 대한 의존도를 줄일 수 있습니다.

- 지속적인 지식 습득 및 유지: 모델이 새로운 데이터를 섭취하고 (예: 학술 논문) 기존 지식과 컨텍스트 내 추론을 사용하여 자체적인 설명과 함의를 대량으로 생성할 수 있게 됩니다. 이러한 자기 표현(self-expression)과 자기 개선(self-refinement)의 반복적인 루프는 추가적인 외부 감독 없이도 모델이 희귀하거나 과소 대표되는 주제에 대해 지속적으로 개선될 수 있도록 합니다.

- 사고의 사슬 (Chain-of-Thought, CoT) 모델과의 시너지: SEAL은 CoT 트레이스를 생성하도록 훈련된 추론 모델에 상호 보완적인 메커니즘을 제공합니다. 모델은 추론 도중에 가중치 업데이트를 수행하여 현재 궤적을 안내하거나, 추론 완료 후 핵심 통찰력을 파라미터에 증류하여 내재화된 학습(internalized learning)을 통해 미래 추론을 향상시킬 수 있습니다.

SEAL은 LLM이 단순히 정적인 도구를 넘어, 변화하는 환경과 요구에 맞춰 스스로 학습하고 발전하는 능동적인 존재가 될 수 있음을 보여주는 중요한 진보입니다.

'Paper Review' 카테고리의 다른 글

| "Wider or Deeper? Scaling LLM Inference-Time Compute with Adaptive Branching Tree Search" 논문 리뷰 (0) | 2025.07.06 |

|---|---|

| SpeechSSM 논문 리뷰 (1) | 2025.07.06 |

| HyperCLOVA X THINK 리뷰 (1) | 2025.07.03 |

| Hunyuan-A13B 리뷰 (1) | 2025.07.03 |

| "VLRM: Vision-Language Models act as Reward Models for Image Captioning" 논문 리뷰 (3) | 2025.06.15 |