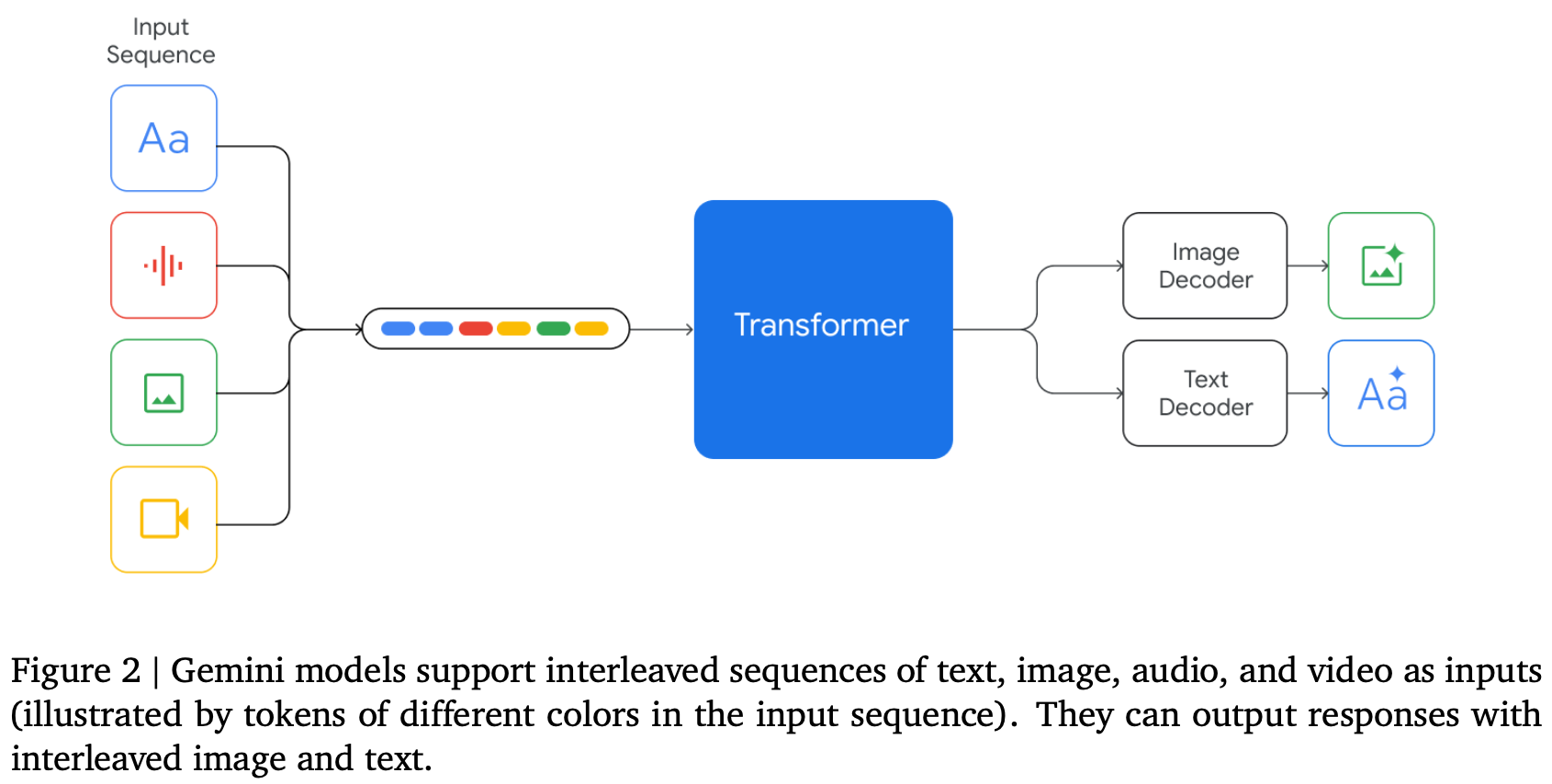

이 논문은 이미지, 오디오, 비디오, 텍스트 이해 능력 전반에 걸쳐 뛰어난 성능을 보이는 새로운 다중 모달 모델 제품군인 Gemini를 소개합니다. Gemini는 Google에서 개발되었으며, 각 도메인에서 최첨단 이해 및 추론 성능과 함께 모달리티 전반에 걸쳐 강력한 범용 역량을 구축하는 것을 목표로 이미지, 오디오, 비디오 및 텍스트 데이터를 공동으로 학습했습니다.1. Gemini 모델 제품군Gemini 1.0은 세 가지 주요 크기로 제공되며, 각각 다른 계산 제약 조건 및 애플리케이션 요구 사항을 처리하도록 맞춤 제작되었습니다:Gemini Ultra: 가장 강력한 모델로, 추론 및 다중 모달 작업 등 광범위한 고도로 복잡한 작업에서 최첨단 성능을 제공합니다.Gemini Pro: 성능 최적화된 모델로..